¶ Задание

- Реализовать механизм внимания для решения задачи классификации текстов из ЛР №2.

¶ Ход работы

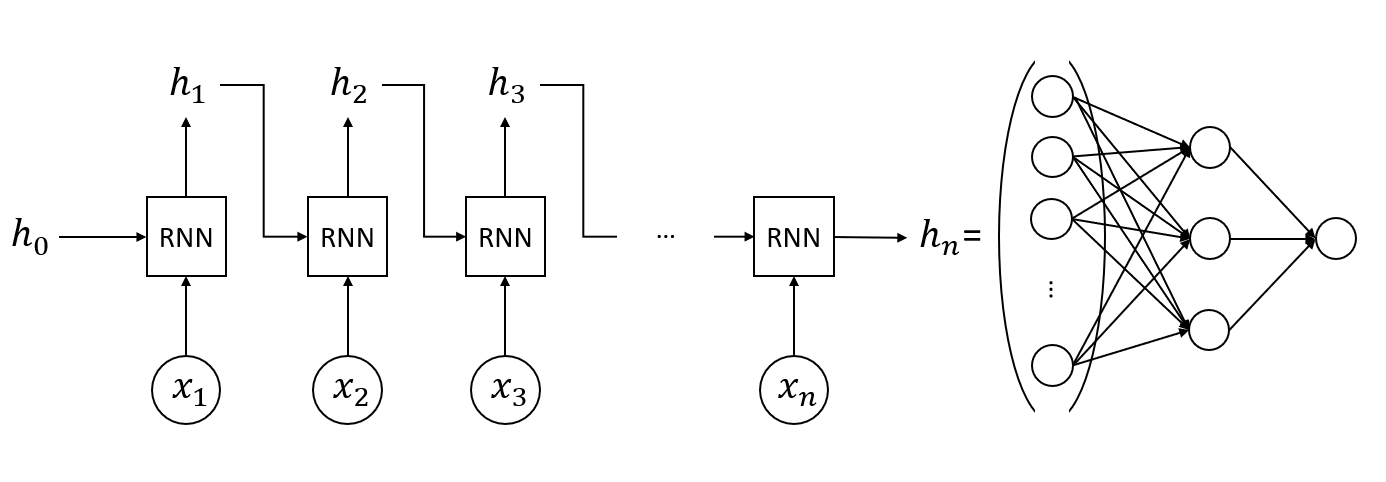

- Возьмите за основу код для решения задачи классификации из второй лабораторной работы. Архитектура вашего решения выглядит примерно таким образом.

-

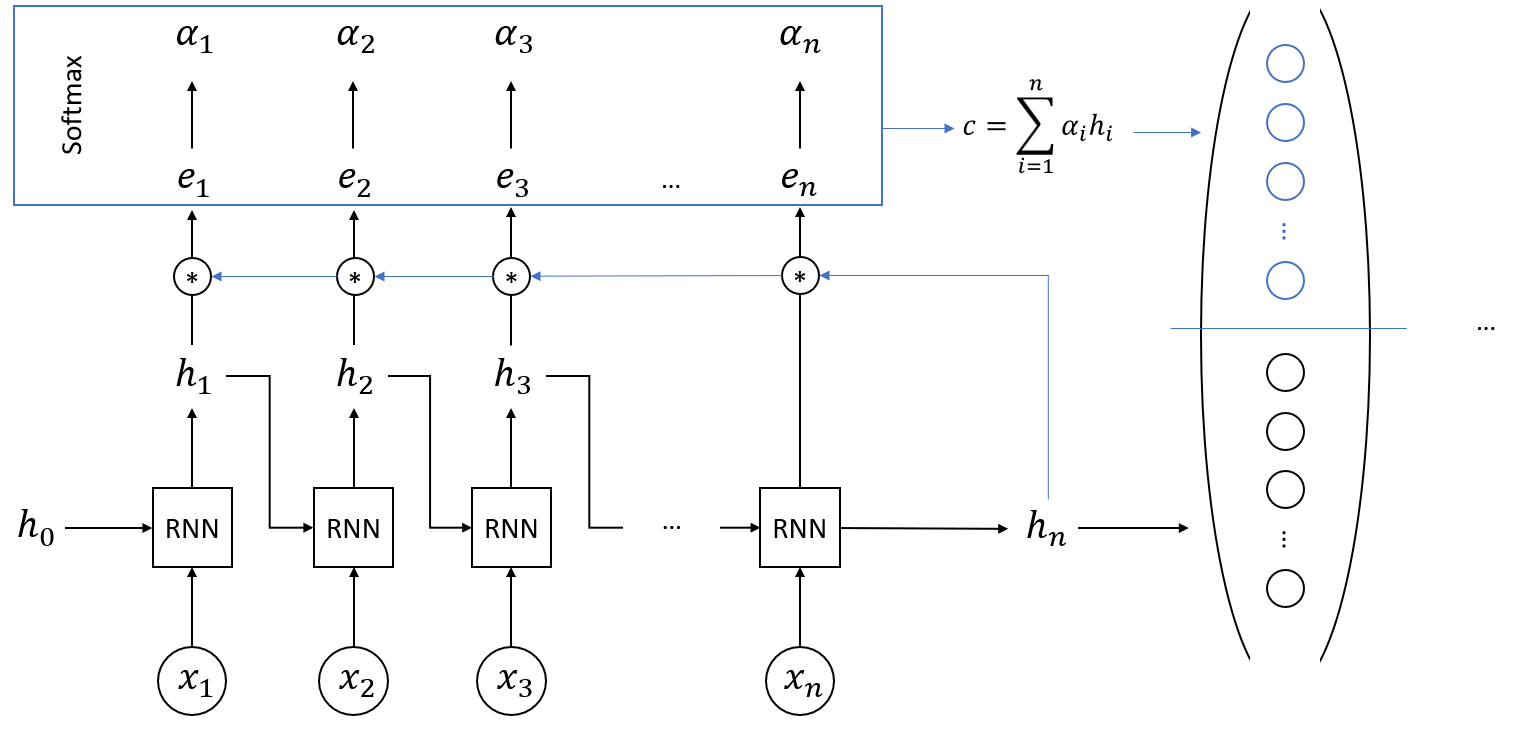

Создайте attention-слой (используя метод

forward()и наследование отnn.Module), который на вход принимает все скрытые состояния (переменная out) и финальное скрытое состояние (переменная h), а возвращает вектор , где:- (скалярное произведение скрытых состояний с итоговым скрытым состоянием);

- (softmax-коэффициенты, полученные для скалярных произведений );

- -- конкатинация векторов-столбцов и (в данном случае появляется больше строк, столбец остается один).

-

Интегрируйте разработанный слой внимания во все три архитектуры нейронных сетей (с использованием RNN, LSTM и GRU), при этом входом полносвязного блока для осуществления классификации будет тот самый вектор . Архитектура будет выглядеть примерно так.

- Посчитайте метрики и сравните их с исходными (без использования слоя внимания).

¶ Критерии приема работы

- Сформирован слой внимания.

- Разработанный слой встроен в архитектуры RNN, LSTM и GRU из ЛР №2.

- Выполнено сравнение метрик.