¶ Основная теория

¶ Цель работы

Научиться выполнять операции с файлами и папка в HDFS. На практике познакомиться с парадигмой вычислений MapReduce. Выполнить агрегации данных с использованием MRJob.

Чтобы существенно упростить выполнение лабораторной работы рекомендуется использовать Visual Studio Code и возможность подключения по SSH:

- воспользуйтесь расширением Remote — SSH и подключитесь через ваш Visual Studio Code на Windows к виртуальной машине с Python

- пишите код с комфортом и подсветкой синтаксиса (для этого не забудьте установить расширение Python и активировать его на вкладке Extensions после подключения к виртуальной машине)

- запускайте код непосредственно на виртуальной машине из терминала внутри Visual Studio Code, либо в отдельном терминале

¶ Предварительная подготовка

Для выполнения данной лабораторной работы предварительно необходимо выполнить ЛР 2: у вас должен быть работающий кластер с Namenode и Datanode

Напоминание: на машинах с Hadoop должен быть установлен

Java Development Kit 11. Версия имеет значение!

- подключитесь к виртуальной машине Namenode

- добавьте в конец файла

~/.bashrcследующие строки:export PATH=$PATH:/usr/local/hadoop/bin/export HADOOP_HOME=/home/mikhail/hadoop-3.3.6

- не забудьте проверить пути!

- чтобы изменения применились перезапустите терминал командой

source ~/.bashrc - отредактируйте файлы

yarn-site.xmlиmapred-site.xmlв папкеhadoop-3.3.6/etc/hadoop(проверьте путь, у вас может быть другая версия Hadoop) следующим образом:

yarn-site.xml

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<!-- Site specific YARN configuration properties -->

<property>

<name>yarn.scheduler.capacity.root.support.user-limit-factor</name>

<value>2</value>

</property>

<property>

<name>yarn.nodemanager.disk-health-checker.min-healthy-disks</name>

<value>0.0</value>

</property>

<property>

<name>yarn.nodemanager.disk-health-checker.max-disk-utilization-per-disk-

percentage</name>

<value>100.0</value>

</property>

<property>

<name>yarn.application.classpath</name>

<!--Не забудьте здесь заменить пути!-->

<value>

/home/mikhail/hadoop-3.3.6/etc/hadoop,

/home/mikhail/hadoop-3.3.6/share/hadoop/common/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/common/lib/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/hdfs/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/hdfs/lib/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/mapreduce/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/mapreduce/lib/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/yarn/*,

/home/mikhail/hadoop-3.3.6/share/hadoop/yarn/lib/*

</value>

</property>

</configuration>

mapred-site.xml

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

<property>

<!--Не забудьте здесь заменить пути!-->

<name>yarn.app.mapreduce.am.env</name>

<value>HADOOP_MAPRED_HOME=/home/mikhail/hadoop-3.3.6</value>

</property>

<property>

<name>mapreduce.map.env</name>

<value>HADOOP_MAPRED_HOME=/home/mikhail/hadoop-3.3.6</value>

</property>

<property>

<name>mapreduce.reduce.env</name>

<value>HADOOP_MAPRED_HOME=/home/mikhail/hadoop-3.3.6</value>

</property>

</configuration>

- запустите Namenode и Datanode (сделать так, чтобы работал HDFS-кластер; убедитесь, что Datanode связана с Namenode, это должно отображаться в дашборде)

- перейдите в папку

hadoop-3.3.6/sbinна Namenode и выполните команду./start-yarn - убедитесь в отсутствии ошибок и откройте в браузере страницу <адрес Namenode>:8088

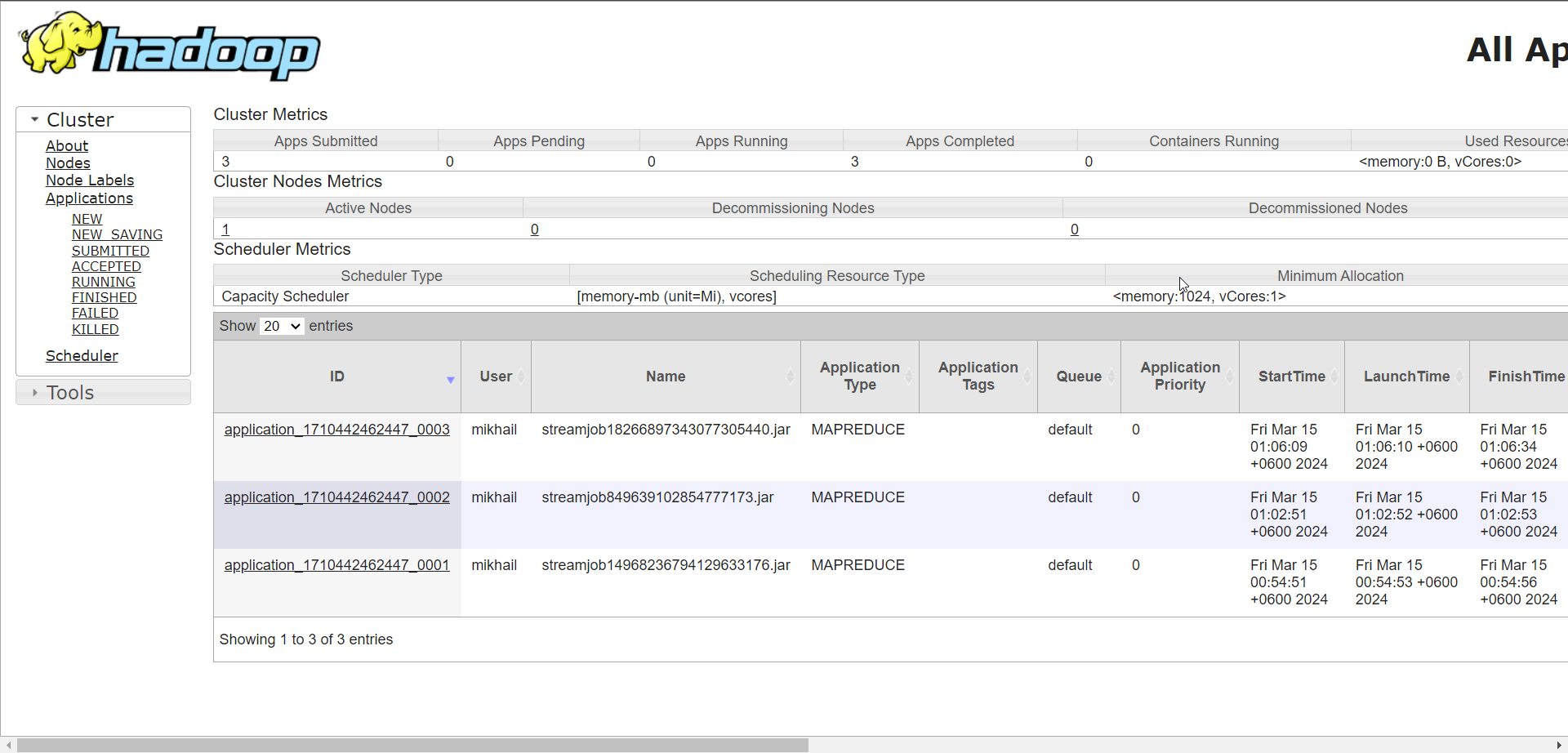

- вы увидите что-то такое (цифры могут отличаться):

- вывод команды

jpsна Namenode при этом должен быть примерно таким (с компонентами NodeManager и ResourceManager):

- создайте в HDFS новую папку с любым названием (напоминание: статья с командами)

Замечание: при работе с HDFS может возникнуть предупреждение

Name node is in safe mode. В этом случае файловая система HDFS доступна "только для чтения". Namenode может автоматически переходить в безопасный режим. Чтобы выключить безопасный режим используйте командуhdfs dfsadmin -safemode leave

Namenode даже после выполнения указанной команды может оставаться в безопасном режиме; одна из основных причин — отсутствие свободного места на диске

- установите Python на Namenode (он должен быть установлен по умолчанию, проверьте командой

python3 --version), создайте и активируйте виртуальное окружение (рекомендуется организовать отдельную папку) - установите библиотеку

MRJobи библиотеку для выполнения HTTP-запросов (в базовом варианте —requests; если хотите выполнять запросы асинхронно — используйтеhttpxили аналоги) - попробуйте переписать стандартный счетчик слов (который был в Google Colab) и запустить его так, чтобы данные брались из HDFS (для этого в HDFS заранее рекомендуется скопировать файл с каким-либо текстом)

- задачи MapReduce запускаются командой

python3 <имя файла python> -r hadoop hdfs:///<путь к файлу или папке в HDFS>(например, если в HDFS создана папка /test и в ней расположены исходные данные в виде нескольких файлов, то можно указать путьhdfs:///test— в этом случае на вход первому мапперу будут поступать строки из всех файлов папки)

При желании можно использовать флаг

--output-dirдля указания папки, куда будут сохраняться результаты выполнения задачи MapReduce; помните, что вы указываете путь в HDFS

В целях отладки можно запускать код командой

python3 <имя файла python> <путь к файлу или папке со входными данными>;MrJobпозволяет работать с файлами и папками в локальной файловой системе

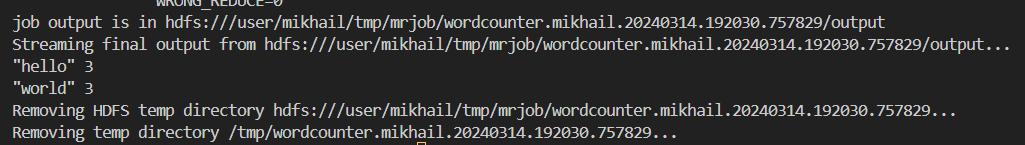

- при успешном выполнении задач MapReduce вы увидите примерно такой вывод:

- в выводе содержится информация о расположении в HDFS выходных данных (при этом они также и выводятся)

- если возникают ошибки — попробуйте отладить их самостоятельно или попробуйте уточнить у преподавателя

Если все хорошо, то пора попробовать решить задачки, которые похожи на реальные задачи BigData (ну только масштаб все же меньше).

¶ Задачи работы:

- воспользуйтесь API расписания ОмГТУ (небольшая документация к нему ниже):

- выберите 5 любых преподавателей

- скачайте расписание выбранных преподавателей на текущий семестр и сохраните его в виде множества файлов JSON (в одном файле расписание преподавателя на неделю)

- загрузите все JSON-файлы в созданную папку в HDFS

- воспользуйтесь парадигмой MapReduce и библиотекой MRJob. Решите следующие задачи:

- найти общее количество пар за семестр у каждого преподавателя

- для каждого преподавателя определить дисциплины, которые преподаватель чаще всего ведёт (одна дисциплина)

- для каждого преподавателя найти аудитории, в которой преподаватель чаще всего ведёт занятия (одна аудитория)

- для каждого преподавателя найти количество пар за семестр у преподавателя, разделённое по лабораторным, практическим и лекционным занятиям

- обратите внимание на следующие подсказки:

- ключ в парах <ключ, значение> может быть составным

- помните, что на вход MapReduce можно указать папку с файлами

- сохраняйте текстовые данные в кодировке

UTF-8 - изучите примеры кейсов использования MrJob

¶ Методы API расписания ОмГТУ

- Поиск преподавателей по имени: https://rasp.omgtu.ru/api/search?term=Шарун&type=person (здесь можно узнать ID преподавателя)

- Поиск групп по названию: https://rasp.omgtu.ru/api/search?term=МО-&type=group (здесь можно узнать ID группы)

- Поиск аудитории: https://rasp.omgtu.ru/api/search?term=8-20&type=auditorium (здесь можно узнать ID аудитории)

- Расписание группы: https://rasp.omgtu.ru/api/schedule/group/493?start=2023.09.18&finish=2023.09.24&lng=1

- Расписание преподавателя: https://rasp.omgtu.ru/api/schedule/person/782898?start=2023.09.25&finish=2023.10.01&lng=1

- Расписание аудитории: https://rasp.omgtu.ru/api/schedule/auditorium/178?start=2023.09.25&finish=2023.10.01&lng=1

¶ Критерии приемки работы:

- продемонстрирован код на Python для получения данных с использованием API расписания ОмГТУ

- продемонстрировано наличие исходных данных в HDFS

- продемонстрирована реализация решения задач на Python с использованием MapReduce

- продемонстрирован запуск решения задачи на виртуальной машине с Python с загрузкой данных из HDFS